تجزیه و تحلیل داده شامل مجموعه ای از فرآیندها و فعالیت های منسجم و هدفمندی است که هدف اصلی آن دستیابی به داده

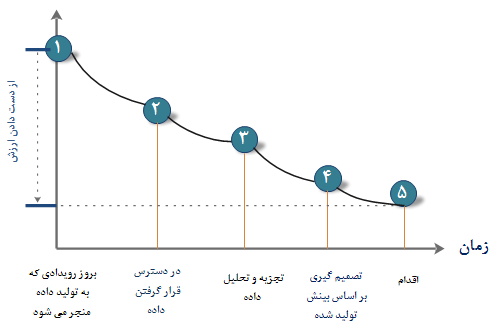

و استخراج اطلاعات مفید است . از نتایج تجزیه و تحلیل داده در حوزه های مختلفی نظیر شناسایی ریسک ، کشف تقلب ، بهبود عملکرد فرآیندهای کاری ، بررسی اثربخشی فرآیند ها، تسهیل در تصمیم گیری کسب و کار و موارد متعدد دیگری استفاده می گردد . اطلاعات در طول زمان ارزش خود را از دست می دهند و مهم است که بتوان در سریع ترین زمان ممکن از اطلاعات در فرآیند تصمیم گیری استفاده بعمل آورد . تاخیر در جمع آوری داده ، تجزیه و تحلیل اطلاعات ، تصمیم گیری و در نهایت اجرای تصمیمات باعث از دست رفتن فرصت های بی شماری در فضای به شدت رقابتی امروزی می گردد . در شکل 1 ، ازدست دادن ارزش اطلاعات در طول زمان ، از زمان ایجاد داده بر اثر یک رویداد تا زمان اقدام بر اساس تصمیم گیری مبتنی بر بینش ، نشان داده شده است . در گذشته ، رویدادی که به تولید داده منجر می گردید اغلب در سیستم های عملیاتی یک سازمان ( نظیر برنامه مدیریت ارتباط با مشتریان ) اتفاق می افتاد . هم اینک در فضای خارج از سازمان ( به عنوان نمونه شبکه های اجتماعی ) نیز این رویداد با سرعت

به مراتب بیش تری محقق می گردد . یک سازمان موفق ، سازمانی است که بر تمامی این رویدادها اشراف عملیاتی داشته باشد و بتواند با جمع آوری ، ذخیره سازی ، تجزیه و تحلیل و اقدام سریع برای خود یک مزیت رقابتی نسبت به سایر رقبا ایجاد نماید .

شکل 1 : از دست دادن ارزش داده در طول زمان

شکل 1 : از دست دادن ارزش داده در طول زمان

برای بهره برداری حداکثری از ارزش اطلاعات توجه به نکات کلیدی زیر حائز اهمیت است :

- شناسایی اطلاعات حیاتی

- شناسایی دقیق مصرف کنندگان اطلاعات

- شناسایی مکان منابع اطلاعات

- جمع آوری و گروه بندی اطلاعات

- استفاده از کانال های ارتباطی مناسب جهت درگیر کردن تمامی ذینفعان و دریافت بازخورد آنها

موارد فوق ، بر جایگاه حیاتی یک چرخه حیات مناسب برای تجزیه و تحلیل داده تاکید می نماید .هدف

مجموعه مقالات " چرخه حیات تجزیه و تحلیل داده " ، آشنایی با یکی از چرخه های حیات معتبر به منظور تجزیه و تحلیل داده با تمرکز بر روی کلان داده ها و یا داده های عظیم است . در

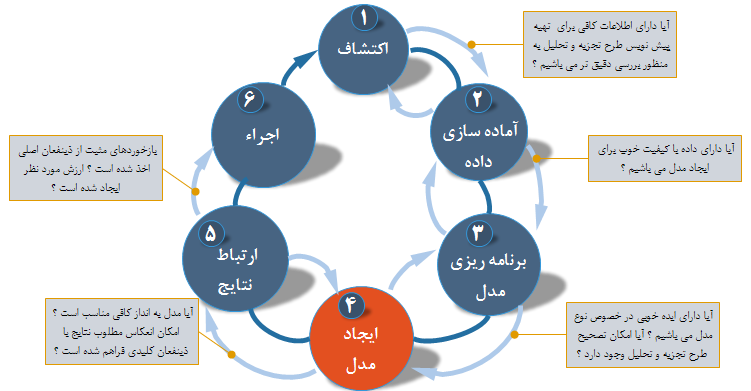

بخش اول ضمن آشنایی با کلیات این چرخه به این موضوع اشاره گردید که چرخه حیات فوق از شش مرحله مهم و استراتژیک تشکیل شده است که در ذیل هر مرحله مجموعه ای از فعالیت ها تعریف می شود . در

بخش دوم با تمرکز بر روی اولین مرحله چرخه حیات که از آن با نام اکتشاف داده یاد می شود ، با مجموعه فعالیت های آن آشنا شدیم . در

بخش سوم با تمرکز بر روی دومین مرحله چرخه حیات تجزیه و تحلیل داده که از آن با نام آماده سازی داده نام برده می شود با مجموعه فعالیت های آن آشنا شدیم. در

بخش چهارم به سراغ مرحله سوم چرخه حیات تجزیه و تحلیل داده رفتیم و با مجموعه فعالیت های لازم جهت برنامه ریزی مدل آشنا شدیم . در این بخش با تمرکز بر روی چرخه حیات تجزیه و تحلیل داده با چهارمین مرحله آن که ایجاد مدل است ، آشنا خواهیم شد .

شکل 2 : مراحل مختلف چرخه حیات تجزیه و تحلیل داده

شکل 2 : مراحل مختلف چرخه حیات تجزیه و تحلیل داده

مرحله چهارم : ایجاد مدل

در این مرحله ، تیم داده دیتاست هایی را برای یادگیری ، تست و سایر اهداف مدل ایجاد می نماید. دانشمندان داده به کمک دیتاست های فوق قادر به ایجاد مدل تحلیلی و آموزش آن می باشند ( داده آموزشی ) . همچنین از برخی داده ها جهت تست مدل (داده تستی ) استفاده می گردد. در حین فرآیند فوق ، می بایست این اطمینان ایجاد گردد که دیتاست های تستی و آموزشی برای تکنیک های تحلیلی و مدل سازی به اندازه کافی قوی و مناسب می باشند . از دیتاست های آموزشی جهت انجام آزمایش های اولیه و از دیتاست های تستی برای اعتبارسنجی رویکرد مورد نظر ( پس از اجرای مدل و آزمایش های اولیه ) استفاده می گردد .

در مرحله ایجاد مدل ، نشان داده شده در شکل 2 ، هدف ایجاد یک مدل تحلیلی است که اولا مناسب با داده های آموزشی باشد و ثانیا ارزیابی و یا امتیازدهی آن در مقابل داده تستی با موفقیت انجام شده باشد . مراحل برنامه ریزی مدل و ایجاد مدل تا حدودی می توانند هم پوشانی داشته باشند و در عمل ،

ممکن است بین دو مرحله فوق به دفعات به عقب و جلو حرکت کرد تا به مدل مطلوب نهایی دست پیدا کنیم .

با این که تکنیک های مدل سازی و منطق نیازمند ایجاد مدل هایی است که می تواند خیلی هم پیچیده باشند ولی در عمل ، مدت زمان واقعی این مرحله در مقایسه با زمانی که صرف آماده سازی داده و تعریف رویکردها می گردد ، می تواند به مراتب کوتاه تر باشد . بطور کلی ، در مراحل آماده سازی و یادگیری داده ( بند دوم فاز اول ) و ارایه یافته ها ( فاز 5 ) زمان زیادی صرف می شود و مراحل 3و 4 با این که از دیدگاه مفهومی به مراتب پیچیده تر می باشند ولی با سرعت به مراتب بیشتری انجام می شوند . اجرای مدل های تعریف شده در فاز سوم ، یکی از فعالیت های تعریف شده در مرحله چهارم است .

همچنین در این فاز ، کاربران مدل هایی را به کمک پکیج های نرم افزارهای تحلیلی نظیر

R و

SAS با اهداف تستی ، بر روی دیتاست های کوچک و با مقیاس کم اجراء می نمایند تا هم مدل و هم نتایج آن را ارزیابی نمایند.

به عنوان نمونه آیا مدل برای اکثریت داده پاسخگو و دارای قدرت پیش بینی قوی می باشد . در این مقطع ، مدل ها به منظور بهینه سازی نتایج پالایش خواهند شد ( نظیر اصلاح متغیرهای ورودی یا کاهش متغیرهای مرتبط در صورت لزوم ) . در مرحله سوم ، تیم داده ممکن است دارای برخی اطلاعات و دانش لازم نسبت به متغیرهای وابسته یا ویژگی های مشکل ساز داده باشد . بدیهی است در زمان اجرای مدل ، ممکن است برخی از آنها تایید و برخی دیگر نادیده گرفته شوند . زمانی که درگیر جزئیات ایجاد مدل ها و انتقال داده می شویم ، اغلب تصمیمات کوچک متعددی در رابطه با داده و رویکردهای موجود برای مدل سازی گرفته می شود . این جزئیات می تواند به سادگی و زمانی که پروژه به اتمام رسید به فراموشی سپرده شوند ، بنابراین ضروری است که نتایج و منطق مدل در این مرحله مستند گردد . علاوه بر این ، ثبت هر نوع فرضیه عملیاتی که در فرآیند مدل سازی ایجاد می گردد ، ضروری است .

ایجاد مدل های قوی که برای یک وضعیت خاص مناسب باشند ، مستلزم در نظر گرفتن ملاحظات متعددی است تا این اطمینان ایجاد گردد که مدل های ایجاد شده ، در نهایت اهداف لیست شده در مرحله اول را تامین می نمایند . درچنین مواردی پرسش های متعددی مطرح می گردد :

- آیا عملکرد مدل بر اساس داده تستی ، دقیق و معتبر است ؟

- آیا خروجی یا رفتار مدل برای حوزه کارشناسان و متخصصین قابل قبول است و به سوالات موجود به درستی پاسخ می دهد؟

- آیا مقادیر پارامترهای در نظر گرفته شده برای مدل ، رضایت مندی لازم را با توجه به حوزه عملکردی مدل ایجاد می نماید؟

- آیا مدل به اندازه کافی دقیق است تا پاسخگوی اهداف تعریف شده باشد؟

- آیا مدل از خطاهای غیرقابل تحمل پیش گیری می نماید ؟

- آیا به داده و یا ورودی بیش تر نیاز است ؟

- آیا لازم است برخی از ورودی ها تبدیل و یا حذف گردند ؟

- آیا نوع مدل انتخاب شده از الزامات زمان اجراء حمایت می نماید ؟

- آیا جهت پاسخ گویی به مسائل کسب و کار به یک شکل متفاوت دیگر از مدل نیاز است ؟ اگر پاسخ مثبت است ، به فاز برنامه ریزی مدل برگردید و رویکرد مدل را بازبینی نمائید .

زمانی که تیم داده به این نتیجه برسد که مدل برای حل مساله به اندازه کافی قوی می باشد ، می تواند به مرحله بعدی در چرخه حیات تجزیه و تحلیل داده حرکت کند .

ابزارهای متداول برای ایجاد مدل

برای ایجاد مدل

می توان از ابزارهای متعدد با طیف گسترده ای از توانمندی ها از تحلیل های آماری گرفته تا نرم افزارهای داده کاوی استفاده کرد . در ادامه به برخی از این ابزارهای متداول اشاره می گردد . بدیهی است برخی از

close source بوده و به صورت کاملا تجاری ارایه می شوند و برخی دیگر

open source می باشند و می توان معمولا به صورت کاملا رایگان از آنها استفاده کرد .

در آغاز اشاره ای مختصر به ابزارهای

close source :

- SAS Enterprise Miner : به کمک نرم افزار فوق امکان ایجاد و اجرای مدل های پیش گویانه و تشریحی بر اساس حجم بالایی از داده وجود دارد تا بتوان بر اساس نتایج ، تصمیم گیری سریع تر و مبتنی بر تحلیل داده صحیح و دقیق را اتخاذ کرد . SAS Enterprise Miner یک ابزارداده کاوی تحلیلی پیشرفته است که به کاربران کمک می کند به سرعت بتوانند مدل های تشریحی و پیش گویانه را ایجاد نمایند . به کمک رابط کاربر گرافیکی جذاب آن ، کاربران می توانند فرآیندهای داده کاوی را به کمک پنج مرحله نمونه برداری ، اکتشاف ، اصلاح ، مدل سازی و ارزیابی انجام دهند . همچنین کاربران قادر به ایجاد یک جریان فرآیندی به کمک امکانات تعبیه شده در این نرم افزار می باشند .

- SPSS Modeler : این نرم افزار توسط شرکت IBM ارایه شده است و هم اینک تحت عنوان IBM SPSS Modeler در اختیار علاقه مندان قرار می گیرد . نرم افزار فوق متدهای لازم جهت بررسی و تحلیل داده را به کمک یک رابط کاربر گرافیکی ارایه می نماید . این نرم افزار دارای طیف گسترده ای از الگوریتم ها و تکنیک های تجزیه و تحلیل نظیر تجزیه و تحلیل متن ، تجزیه و تحلیل موجودیت و مدیریت تصمیم گیری و بهینه سازی است . از دیگر ویژگی های جالب این نرم افزار ارایه بینش لازم در جهت تصمیم گیری دقیق و به موقع به صورت near real time و حمایت از یک محیط تصمیم گیری یک دست در تمامی سازمان است .

- Matlab : یک زبان برنامه نویسی سطح بالا که امکان انجام طیف گسترده ای از تجزیه و تحلیل داده ، الگوریتم ها و اکتشاف داده را فراهم می نماید .

- Alpine Miner : این نرم افزار با ارایه یک رابط کاربر گرافیکی در لایه front end ، این امکان را در اختیار کاربران قرار می دهد تا بتوانند جریان های کاری تحلیلی را ایجاد نمایند و با ابزارهای کلان داده و پلت فرم ها در back end ارتباط برقرار نمایند .

- STATISTICA و Mathematica : از نرم افزارهای فوق نیز در ابعاد وسیعی به عنوان ابزارهای داده کاوی و تحلیلی استفاده می گردد .

و اما نرم افزارهای

open source :

- R و PL/R : به برخی از ویژگی های R در مرحله برنامه ریزی اشاره گردید . PL/R یک زبان برنامه نویسی رویه ای برای PostgreSQL with R می باشد. استفاده از رویکرد فوق بدین معنی است که دستورات R را می توان در بانک اطلاعاتی اجراء کرد . روش فوق در مقایسه با حالتی که R در حافظه اجراء می گردد ، دارای عملکرد و قابلیت مقیاس پذیری بهتری است.

- Octave ، یک زبان برنامه نویسی رایگان برای مدل سازی محاسباتی است که دارای برخی از قابلیت های Matlab است و با توجه به رایگان بودن ، در اکثر دانشگاه ها از آن جهت تدریس یادگیری ماشین استفاده می گردد .

- WEKA ، یک پکیچ نرم افزاری رایگان داده کاوی به همراه یک کارگاه تحلیلی است . توابع ایجاد شده در WEKA را می توان درون کدهای جاوا اجراء کرد.

- Python : یک زبان برنامه نویسی است که امکانات متعددی را برای یادگیری ماشین ، تجزیه و تحلیل و بصری سازی داده ارایه می نماید .

خلاصه

در این بخش با تمرکز بر روی مرحله

چهارم چرخه حیات تجزیه و تحلیل که از آن با نام ایجاد مدل یاد می شود با فعالیت های مرتبط با آن و همچنین ابزارهای موجود جهت ساخت مدل آشنا شدیم . ایجاد مدل یکی از مراحل مهم در چرخه حیات تجزیه و تحلیل است که با انجام صحیح و تست کارآمدی آن به کمک دیتاست های آموزشی و تستی ، می توان آماده ورود به مرحله ارتباط نتایج شد . مرحله ای که نتایج با ذینفعان به اشتراک گذاشته می شود تا در صورت پذیرش ، زمینه لازم جهت عملیاتی کردن مدل فراهم گردد . در بخش بعدی به سراغ مراحل پنجم و ششم چرخه حیات تجزیه و تحلیل داده خواهیم رفت و با نحوه برقراری ارتباط نتایج و در نهایت عملیاتی سازی و یا اجرای مدل آشنا خواهیم شد .

منابع :

EMC Education Services. Data Science and Big Data Analytics: Discovering, Analyzing, Visualizing and Presenting Data. Wiley, 2015

Bart Baesens,Analytics in a Big Data World: The Essential Guide to Data Science and its Applications. Wiley, 2014

Rachel Alt-Simmons,Agile by Design: An Implementation Guide to Analytic Lifecycle Management,Wiley, 2014